Нет товаров

Цены указаны с учетом НДС

Сетевое оборудование

Сетевое оборудование - адаптеры, коммутаторы, кабели, трансиверы

Ethernet, InfiniBand, Fibre Channel для построения сети хранения данных SAN.

Высокие требования к скорости получения данных от хранилища или перегруженность основной коммникационной сети вычислительной структуры предприятия могут потребовать перехода к параллельной основной, сп...

Сетевое оборудование - адаптеры, коммутаторы, кабели, трансиверы

Ethernet, InfiniBand, Fibre Channel для построения сети хранения данных SAN.

Высокие требования к скорости получения данных от хранилища или перегруженность основной коммникационной сети вычислительной структуры предприятия могут потребовать перехода к параллельной основной, специально предназначенной для связи серверов с хранилищами сети - Storage Area Network (SAN).

Сеть хранения оптимизируется по производительности благодаря использованию специально предназначенного для применения протокола Fibre Channel или протокола со сверхнизкими задержками передачи пакетов InfiniBand, или же в основу берется быстрый Ethernet (10GBase, 25GBase,..) протокол, поскольку сеть хранения подразумевает большой объем трафика.

В каталоге нашего магазина представлено оборудование для следующих протоколов и скорости передачи: Ethernet 10GBase, 25GBase, 40GBase, 50GBase, 100GBase; Fibre Channel 8GFC, 16GFC, 32GFC; InfiniBand FDR (40/56Gb/s), EDR (100Gb/s).

В зависимости от количества серверов и хранилищ, объединяемых сетью хранения, а также требований к бесперебойной доступности данных, сеть может быть как очень простой, содержащей адаптеры интерфейса (Host Bus Adapter) в серверах и хранилищах и один коммутатор (или даже без него), так и развитой, содержащей сотни узлов с коммутаторами нескольких уровней.

Выбор конкретной реализации сети и интерфейса в ее основе определяется в первую очередь техническими требованиями к пропускной способности (максимальный поток, максимально допустимые задержки передачи) и требованиями к доступности данных. Немаловажны также требования к управлению сетевыми устройствами и управлению разделяемыми правами доступа к разделам общего пространства хранения предприятия. Только после этого можно говорить о стоимости, поскольку покупка оборудования, не отвечающего заданным требованиям, становится бессмысленным мероприятием.

Мы предлагаем все компоненты сети - адаптеры, коммутаторы, оптические модули и кабели как прямого подключения, так и оптоволоконные от ведущих производителей в каждой из областей.

Помимо сетевого оборудования, мы поставляем готовые серверы Supermicro и системы хранения данных - все необходимые компоненты ИТ инфраструктуры предприятия.

Сетевое оборудование Нет товаров в этой категории.

Подкатегории

Ethernet

Адаптеры, коммутаторы для сети Ethernet. Скорость передачи 10G (10GBASE), 40G, 50G (50GBASE), 100G (100GBASE), 200G.

InfiniBand

Решения на базе InfiniBand Mellanox

Объем обрабатываемой информации растет каждую минуту благодаря смартфонам, социальным сетям, потоковым видео и прочим системам, генерирующим большие объемы данных. Все они требуют широких каналов передачи, чтобы справляться с огромным количеством передаваемых данных.

Из-за экспоненциального роста данных, генерируемых во всем мире и росту приложений, использующих массированную обработку данных в реальном времени для высокопроизводительных вычислений, аналитики данных, бизнес-аналитики, национальной безопасности и приложений «Интернет вещей», рынок требует более быстрых и эффективных решений для межсетевых соединений.

Согласно отчета "2016+ HPC" компании Intersect360 (2 и 3 квартал 2016 года), InfiniBand по-прежнему является предпочтительным высокопроизводительным системным межсоединением.

Инсталляции InfiniBand в области высокопроизводительных вычислений примерно в два раза превышают совокупные установки Ethernet (10G, 40G и 100G).

Обзор интерфейса Infiniband

Развитием и стандартизацией технологий занимается InfiniBand Trade Association. В настоящее время уже реализованы семь поколений протокола.

Производительность Поколение: SDR DDR QDR FDR-10 FDR EDR HDR NDR Эффективная пропускная способность, Гбит/с, на 1x шину 2 4 8 10 14 25 50 Эффективные скорости для 4x и 12x шин, Гбит/с 8, 24 16, 48 32, 96 41.25, 123.75 54.54, 163.64 100, 300 200, 600 Кодирование (бит) 8/10 8/10 8/10 64/66 64/66 64/66 Типичные задержки, мкс 5 2.5 1.3 0.7 0.7 0.5 Год появления 2001,

20032005 2007 2011 2014 2017 позднее 2020 Таблица 1. Производительность систем различных поколений

Отличительной особенностью интерфейса Infiniband является минимизация задержек при передаче данных по каналу связи - они в разы меньше, чем у конкурирующих протоколов. За счет этого резко возрастает производительность чувствительной к задержкам системы в целом.

Применение Infiniband

В полной мере преимущества протокола проявляются в высокопроизводительных вычислительных кластерах, требующих интенсивного обмена данными между узлами кластера. Но применение Infiniband этим не ограничивается. Шина с успехом используется для организации быстрого канала синхронизации в небольших (2 - 4 узла) вычислительных кластерах и распределенных системах хранения информации. Протокол также используют даже для прямого подключения хранилища к серверу (DAS) в случае, если необходимо достичь максимальной производительности системы и скорость получения данных от хранилища играет в ней существенную роль.

Сравнение Infiniband с конкурирующими интерфейсами

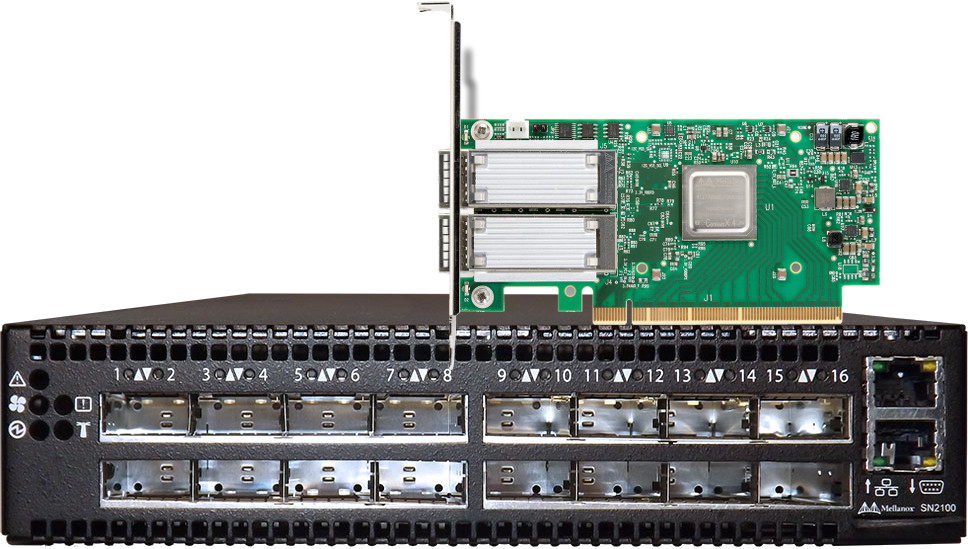

Сравнение производительности и объем необходимого оборудования приведем на основе нового 100Gb/s решения (по материалам Mellanox).

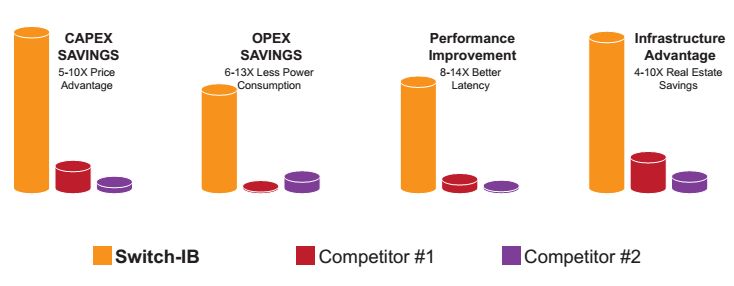

Преимущества, предлагаемые Switch-IB. Switch-IB обеспечивает улучшенную задержку, меньшее энергопотребление, гораздо меньшее количество оборудования и значительное ценовое преимущество. Например, платформа коммутатора Switch IB, работающая на 36 портов EDR и обеспечивающая передачу данных до 7,2 Тбайт / с, дает экономию в размере 4-10 раз по сравнению с решением Cisco, достигающим той же пропускной способности ( 4U Cisco Nexus 6004, работает 96 портов 40 Гбит / с) или с решением Arista 10U ( системы 7050QX).

Рисунок 1. Сравнение производительности Infiniband EDR, Cisco Nexus 6004 (Competitor 1), Arista 7050QX (Competitor 2)

Преимущества EDR (100Gb/s) в сравнении с FDR (56Gb/s)

Классическим сценарием использования преимуществ 100Gb / s линий связи является использование возможностей FDR для серверов и более производительных линий EDR 100Gb / s между коммутаторам стойки (ToR) и коммутаторами агрегации. Это позволяет использовать агрегацию на основе Switch-IB с наивысшей производительностью, имея более высокий уровень портов FDR в ToR, используя соотношение 2: 1 между нисходящими и восходящими портами, которое обеспечивает неблокирующую топологию.

Например, возьмем кластер из 3888 узлов. Сконфигурированный как FDR, кластер требует шесть шасси коммутатора агрегации и 216 переключателей Top-of-Rack (с 18 портами восходящей и нисходящей линии связи), чтобы создать неблокирующий сценарий 1: 1. Но с коммутатором EDR IB (100Gb/s) для поддержания сценария блокировки (соотношение 2: 1) требуется только три шага коммутатора агрегации (связь в два раза по ширине полосы) и 162 коммутатора Top-of-Rack (с 12 восходящими и 24 портами нисходящей линии связи) , Это экономит 37% на оборудовании в центре обработки данных и 25% на потреблении электроэнергии за счет использования меньшего количества коммутаторов.Размер кластера,

суммарная пропускная способностьПреимущество в затратах

на оборудованиеПреимущество в

затратах электроэнергии648 узлов - 72Tb/s 28% 5% 1296 узлов - 145Tb/s 37% 25% 3888 узлов - 435Tb/s 37% 25% 11664 узлов - 1.3Pb/s 37% 25% Таблица 2. Выигрыш при переходе с FDR к EDR

Оборудование InfiniBand Mellanox сгруппировано по типу и принадлежности к определенному протоколу. Перейдите в раздел:

Адпатеры HDR 200Gb/s ConnectX-6 VPI

Адпатеры EDR 100Gb/s ConnectX-5 VPI

Адпатеры EDR 100Gb/s ConnectX-4 VPI

Адпатеры FDR 56Gb/s Connect-IB

Адпатеры EDR 40Gb/s ConnectX-3 Pro VPI

Адпатеры EDR 40/56Gb/s ConnectX-3 VPIКоммутаторы HDR 200Gb/s QM8700 series

Коммутаторы EDR 100Gb/s SB7800 Series

Коммутаторы EDR 100Gb/s SB7700 Series

Коммутаторы FDR 56Gb/s SX6710 Series

Коммутаторы FDR 56Gb/s SX6000 SeriesFibre Channel

Fibre Channel адаптеры и коммутаторы для эффективной сети хранения SAN

Сеть Fibre Channel по-прежнему пользуется заслуженным доверием для построения сети передачи данных (SAN). FC планомерно развивается, удваивая скорость передачи с каждым новым поколением протокола.

Протокол Fibre Channel "родился" в 1988 году и изначально предназначался для применения в области суперкомпьютеров. Но впоследствии, применение FC полностью перешло в сферу сетей хранения данных, где долгое время он был практически безальтернативным стандартом. Долгая успешная жизнь Fibre Channel в качестве основного решения для систем хранения привела к тому, что интерфейс а) "вылизан" с точки зрения надежности, эффективности, поддержки со стороны программного обеспечения и драйверов; б) в мире установлено огромное количество Fibre Channel сетей; в) все программное обеспечение, завязанное на системы хранения в обязательном порядке включает всестороннюю поддержку Fibre Channel протокола.

Сравнение Fibre Channel сети с альтернативными решениями

Fibre Channel широко применяется для создания сетей хранения данных (Storage Area Networks), благодаря высокой скорости передачи данных, малой задержке и расширяемости. Однако, в последние годы, область его применения постепенно перемещается в сегмент высокопроизводительных систем и решений, а бюджетный сегмент с успехом осваивается недорогими решениями iSCSI на базе Gigabit Ethernet и 10G Ethernet. Наметилась также тенденция к переносу транспортного уровня протокола FC в тот же Gigabit и 10G Ethernet при помощи протокола FCoE.

Однако, преимущества Fibre Channel по-прежнему востребованы для задач, чувствительных к скорости получения данных от массива хранения. Здесь на первый план выходят такие характеристики среды передачи, как задержка передачи пакетов по каналу, накладные расходы при передаче информации, надежность доставки пакетов на всем протяжении линии связи. Пиковая скорость передачи, при этом, которая заявляется протоколом, отодвигается на вторые роли.

У лиц, принимающих решения для ИТ-центров предприятия, есть широкий выбор технологий и базовых протоколов, которые они могут использовать для подключения серверов к внешнему блочному хранилищу. Часто сравниваются Fibre Channel и iSCSI.

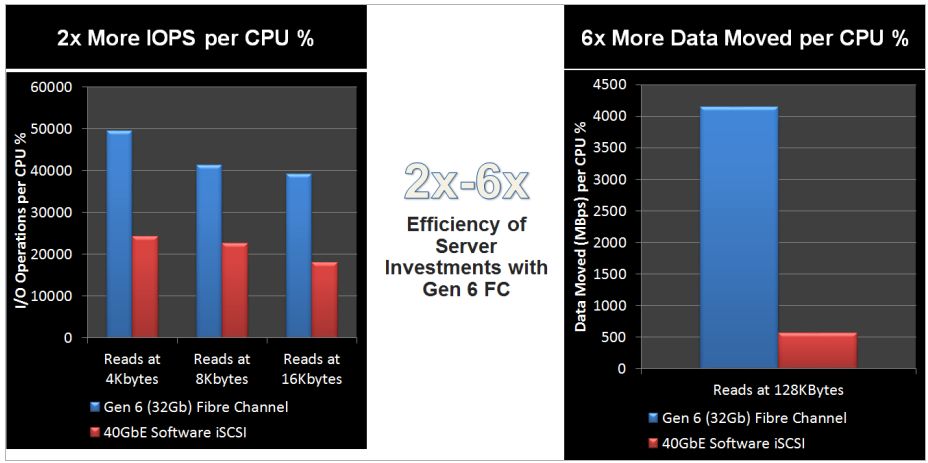

К примеру, приведем сравнение производительности систем, построенных на Gen 6 (32Gb ) Fibre Channel и на 40Gb Software-based iSCSI. Казалось бы - 40 гигабит на 25% больше, чем 32Gb. Значит - iSCSI должен быть если не намного быстрее, то на уровне Fibre Channel. Но нет, за счет своих преимуществ, безусловным победителем в сравнении выходит Fibre Channel (по материалам Qlogic). Сравнения производительности между QLogic Gen 6 FC и Intel XL710 40GbE iSCSI

Рисунок 1. Слева - количество операций ввода-вывода (IOPS) в пересчете на 1 процессор. Синим - 32Gb Fibre Channel, красным - 40GB Sofrware iSCSI. Справа - скорость передачи данных (Mb/s) в пересчете на 1 процессор.

Диаграмма показывает преимущество по обеим ключевым характеристикам канала связи - в количестве операций ввода-вывода 32Gb Fibre Channel в два раза эффективнее, а в скорости передачи данных - преимущество у 32Gb Fibre Channel в шесть раз! Объяснение результатов следующее: инициаторы iSCSI, основанные на программном обеспечении, потребляют циклы ЦП при работе с интенсивными нагрузками ввода-вывода, оставляя небольшой запас для растущих приложений и виртуальных сред. В отличие от программных решений, Fibre Channel является полностью загруженным транспортным механизмом без потерь, который не конкурирует с циклами обработки процессором приложений верхнего уровня, таких как электронная почта или веб-приложения.

Это сравнивались два блочных протокола, ориентированных на интенсивную работу с данными.

Сравнение производительности Fibre Channel разных поколений

Текущая реализация протокола - Gen 6, скорость передачи 32Gb/s. Заявленный одновременно протокол 128Gb/s является объединением воедино четырех 32Gb/s каналов.

Предыдущие поколения:

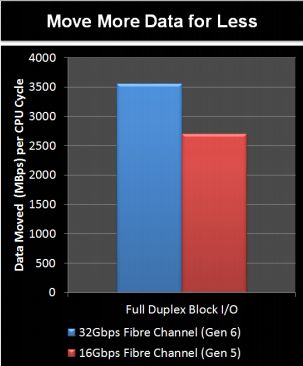

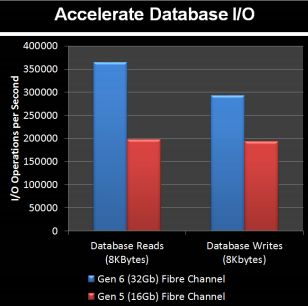

Название Линейная скорость (Gbaud) Производительность ном. (МБ/с) Пропускная способность (МБ/с) Год 1GFC 1,0625 100 103,2 1997 2GFC 2,125 200 206,5 2001 4GFC 4,25 400 412,9 2004 8GFC 8,5 800 825,8 2005 16GFC «Gen 5» 14,025 1 600 1 652 2011 32GFC «Gen 6» 28,05 3 200 3 303 2016 128GFC «Gen 6» 4×28,05 12 800 13 210 2016 От сухих цифр переходим к сравнительным тестам. Сравнение производительности систем с 32GFC и 16GFC в пересчете на 1 процессор.

Рисунок 2. Сравнение производительности систем с 32GFC и 16GFC. Одна и та же система имеет прирост производительности порядка 30% за счет более быстрого интерфейса к хранилищу.

Рисунок 3. Работа с базами данных. Чтение и запись в базу данных. Прирост производительности от 30 до 50%

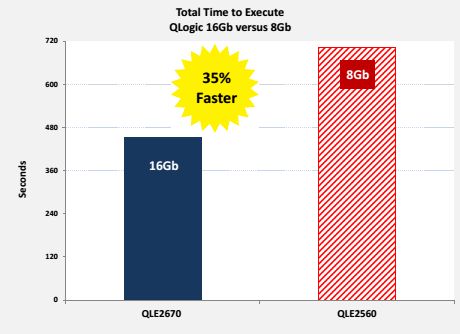

Похожая ситуация получается в сравнении 16Gb/s и 8Gb/s систем

Рисунок 4. Время выполнения задания сервером, связанным с хранилищем 16G/s и 8Gb/s каналом Fibre Channel

Тесты показывают, что используемый в системе протокол Fibre Channel существенно влияет на общую производительность. С каждым поколением прирост составляет от 30 до 50%, то есть тот же самый сервер может работать на 30 - 50% более эффективно только за счет изменения на одно поколение используемого канала передачи Fibre Channel.