Нет товаров

Цены указаны с учетом НДС

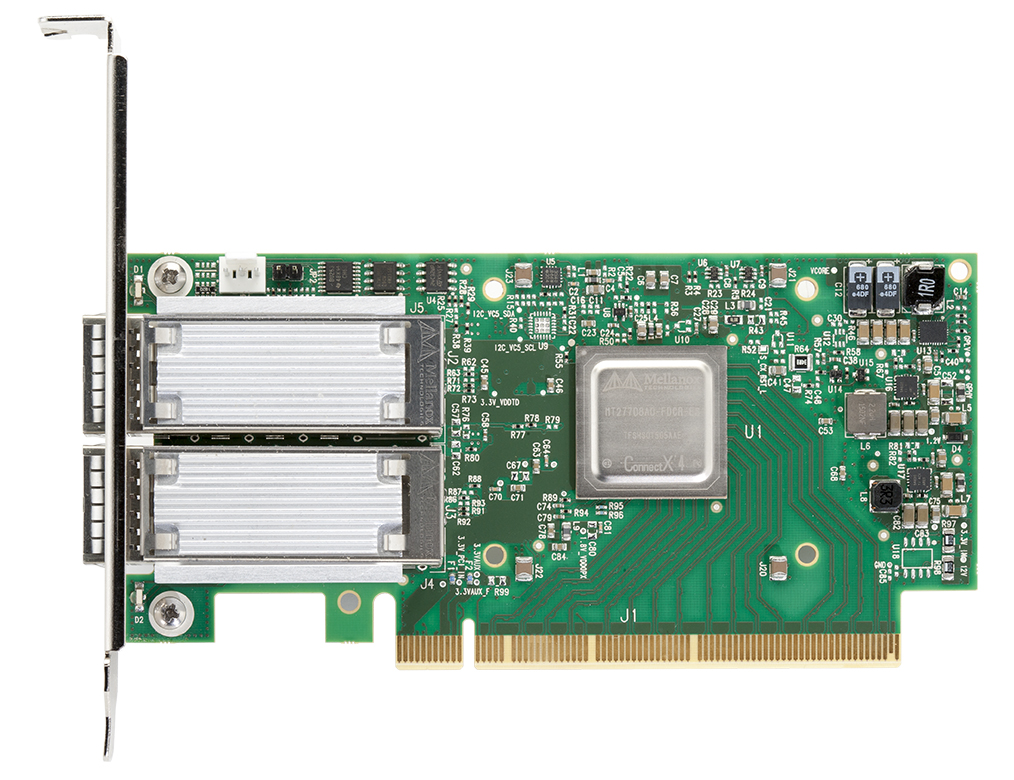

ConnectX-4 VPI Mellanox 100G

Каталог

Адаптеры ConnectX-4 VPI Mellanox

Адаптеры серии ConnectX-4 с технологией Virtual Protocol Interconnect (VPI) поддерживают скорость передачи данных EDR 100Gb/s InfiniBand и 100Gb/s Ethernet.

Стремительный рост объема хранимых и обрабатываемых данных сформировал новые требования к высокоскоростным и высокопроизводительным вычислительным цент...

Адаптеры ConnectX-4 VPI Mellanox

Адаптеры серии ConnectX-4 с технологией Virtual Protocol Interconnect (VPI) поддерживают скорость передачи данных EDR 100Gb/s InfiniBand и 100Gb/s Ethernet.

Стремительный рост объема хранимых и обрабатываемых данных сформировал новые требования к высокоскоростным и высокопроизводительным вычислительным центры и центрам хранения данных. ConnectX-4 обеспечивает исключительно высокую производительность для центров обработки данных, публичных и частных облаков, Web2.0 и обработки больших данных (Big Data).

Основные особенности Connectx-4 VPI Mellanox

Virtual Protocol Interconnect (VPI)

VPI позволяет использовать один и тот же адаптер как в сети передачи данных Infiniband, так и Ethernet. Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

ConnectX-4 VPI Mellanox 100G Товаров: 6.

Адаптер Mellanox VPI MCX453A-FCAT ConnectX-4, 1 port QSFP28, FDR IB (56Gb/s), 40/56GbE, PCIe x8 3.0

Адаптер Mellanox VPI MCX453A-FCAT ConnectX-4 Адаптер Mellanox VPI MCX453A-FCAT ConnectX-4, 1 port QSFP28, FDR IB (56Gb/s), 40/56GbE скорость передачи до EDR 100Gb/s InfiniBand или 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Один порт QSFP28 Шина PCIe3.0, 8 линий Полноразмерная и...

$561Адаптер Mellanox VPI MCX454A-FCAT ConnectX-4, 2 port QSFP28, FDR IB (56Gb/s), 40/56GbE, PCIe x8 3.0

Адаптер Mellanox VPI MCX454A-FCAT ConnectX-4 Адаптер Mellanox VPI MCX454A-FCAT ConnectX-4, 2 port QSFP28, FDR IB (56Gb/s), 40/56GbE скорость передачи до EDR 100Gb/s InfiniBand или 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Два порта QSFP28 Шина PCIe3.0, 8 линий Полноразмерная и...

$674Адаптер Mellanox VPI MCX455A-FCAT ConnectX-4, 1 port QSFP28, FDR IB (56Gb/s), 40/56GbE, PCIe x16...

Адаптер Mellanox VPI MCX455A-FCAT ConnectX-4 Адаптер Mellanox VPI MCX455A-FCAT ConnectX-4, 1 port QSFP28, FDR IB (56Gb/s), 40/56GbE скорость передачи до EDR 100Gb/s InfiniBand или 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Один порт QSFP28 Шина PCIe3.0, 16 линий Полноразмерная и...

$561Адаптер Mellanox VPI MCX456A-FCAT ConnectX-4, 2 port QSFP28, FDR IB (56Gb/s), 40/56GbE, PCIe x16...

Адаптер Mellanox VPI MCX456A-FCAT ConnectX-4 Адаптер Mellanox VPI MCX456A-FCAT ConnectX-4, 2 port QSFP28, FDR IB (56Gb/s), 40/56GbE скорость передачи до EDR 100Gb/s InfiniBand или 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Два порта QSFP28 Шина PCIe3.0, 16 линий Полноразмерная и...

$843Адаптер Mellanox VPI MCX455A-ECAT ConnectX-4, 1 port QSFP28, EDR IB (100Gb/s), 100GbE, PCIe x16 3.0

Адаптер Mellanox VPI MCX455A-ECAT ConnectX-4 Адаптер Mellanox VPI MCX455A-ECAT ConnectX-4, 1 port QSFP28, EDR IB (100Gb/s), 100GbE скорость передачи до EDR 100Gb/s InfiniBand и 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Один порт QSFP28 Шина PCIe 3.0 16 линий В комплекте...

$922Адаптер Mellanox VPI MCX456A-ECAT ConnectX-4, 2 port QSFP28, EDR IB (100Gb/s), 100GbE, PCIe x16 3.0

Адаптер Mellanox VPI MCX456A-ECAT ConnectX-4 Адаптер Mellanox VPI MCX456A-ECAT ConnectX-4, 2 port QSFP28, EDR IB (100Gb/s), 100GbE скорость передачи до EDR 100Gb/s InfiniBand или 100Gb/s Ethernet на каждый порт Поддержка скоростей 1/10/20/25/40/50/56/100 Гбит/с 150 миллионов пакетов в секунду Два порта QSFP28 Шина PCIe 3.0 16 линий Полноразмерная и...

$1,107