Нет товаров

Цены указаны с учетом НДС

Адаптеры Ethernet

Каталог

Серверные адаптеры Ethernet

Невозможно представить себе сервер без адаптера Ethernet. Любой современный сервер имеет встроенный, как правило, двухпортовый гигабитный Ethernet адаптер (контроллер) для связи с внешним миром. Все щаче производители серверных материнских плат стали интегрировать уже 10 Гб / с адаптеры. Поскольку растет вычислител...

Серверные адаптеры Ethernet

Невозможно представить себе сервер без адаптера Ethernet. Любой современный сервер имеет встроенный, как правило, двухпортовый гигабитный Ethernet адаптер (контроллер) для связи с внешним миром. Все щаче производители серверных материнских плат стали интегрировать уже 10 Гб / с адаптеры. Поскольку растет вычислительная мощность серверов - соответственно, растут потребности в скорости получения обрабатываемых данных и скорости передачи обработанных данных от сервера для дальнейшей обработки или хранения.

В соответствии с растущими мировыми объемами данных, развивается интерфейс Ethernet. Вслед за 10 Гб / с были приняты стандарты для скоростей 25-, 50-, 100 Гб / с

Адаптеры Ethernet Mellanox

Mellanox сохраняет свое лидерство в предоставлении высокопроизводительных сетевых технологий, обеспечивая превосходную производительность и масштабируемость с 10/25/40/50/56/100 Gb / s адаптерами Ethernet, позволяющими центрам обработки данных делать больше с меньшими затратами.

Адаптеры Mellanox Ethernet, использующие технологию IBTA RoCE, обеспечивают эффективные RDMA-сервисы, обеспечивая высокую производительность и пропускную способность. Благодаря поддержке IBTA RoCE, значительную прибавку к производительности получают чувствительные к задержкам приложения. Благодаря совместимости на уровне канала в существующей инфраструктуре Ethernet сетевые администраторы могут использовать уже внедренные решения для управления сетями данных.

Приложения, использующие транспорт TCP / UDP / IP, могут получить пропускную способность более 10/25/40/50/56/100GbE. Аппаратная разгрузка и управление потоком в адаптерах Mellanox уменьшают расходы на процессор для передачи IP-пакетов, освобождая его мощности для работы с приложениями. Программное обеспечение для разработки карт данных (DPDK) и ускорителей сокетов дополнительно увеличивает производительность для чувствительных к задержкам приложений.

Особенности адаптеров Ethernet Mellanox

Виртуализация ввода-вывода

Адаптеры Ethernet Mellanox обеспечивают выделенные ресурсы адаптера и гарантируют изоляцию и защиту виртуальных машин (VM) на сервере. Адаптеры Mellanox позволяют менеджерам центров обработки данных лучше использовать сервер и унифицировать LAN и SAN, одновременно снижая затраты, мощность и сложность кабелей.

Оверлейные сети

Новые крупномасштабные облака требуют реализации протоколов Overlay Network для преодоления проблем безопасности и изоляции внутри облака и ограничений на количество существующих VLAN. Адаптеры Mellanox Ethernet с возможностью аппаратной разгрузки для VXLAN, GENEVE и NVGRE приносят уникальное преимущество облачным провайдерам, позволяя им снизить накладные расходы на ЦП и, как следствие, сокращать OPEX и CAPEX, поддерживая больше облачных арендаторов в той же инфраструктуре. Кроме того, аппаратные возможности ConnectX-4 EN и ConnectX-4 Lx EN для инкапсуляции и декапсуляции заголовков протоколов Overlay Networks дополнительно улучшают использование облачных серверов.

Адаптеры Ethernet Нет товаров в этой категории.

Подкатегории

Семейство ConnectX-6...

Ethernet адаптеры ConnectX-6 компании Mellanox

Семейство Ethernet адаптеров ConnectX-6 компании Mellanox включает три группы:

- ConnectX-6 (EN).

- ConnectX-6 Dx. Представлена в августе 2019г. Общедоступна с февраля 2020г.

- ConnectX-6 Lx. Представлена в мае 2020г.ConnectX-6 (EN)

ConnectX-6, первая в мире сетевая карта Ethernet 200 Гбит / с, предлагает лучшую в мире производительность, интеллектуальную разгрузку центрального процессора и внутрисетевые вычисления. ConnectX-6 предоставляет один или два порта со следующими возможностями:

- подключение со скоростью передачи до 200GbE с использованием технологии PAM4,

- задержка передачи менее 800 нс

- 215 миллионов сообщений в секунду.

Адаптеры предлагают новые функции и улучшения производительности по сравнению с предыдущими поколениями, такие как шифрование данных в состоянии покоя и расширенные возможности. хост-цепочки.

Сетевые адаптеры ConnectX-6 доступны для серверов с шиной PCIe Gen 3.0 и Gen 4.0 с вариантами полос x32 или x16. Карты выпускаются в стандартных форм-факторах PCIe и OCP 3.0, а также Mellanox Socket Direct.

ConnectX-6 Dx

ConnectX-6 Dx - это самый передовой облачный SmartNIC в мире, обеспечивающий до двух портов с пропускной способностью 25, 50 или 100 Гбит / с или один порт с возможностью подключения 200 Гбит / с, поддерживающий технологию PAM4 SerDes со скоростью 50 Гбит / с на линию.

Продолжая идти по пути инноваций Mellanox в масштабируемых облачных сетях, ConnectX-6 Dx обеспечивает беспрецедентную производительность и эффективность в любом масштабе.

ConnectX-6 Dx включает инновационные механизмы разгрузки центрального процессора, включая IPsec, встроенное шифрование данных в движении TLS и блочное шифрование AES-XTS. Адаптеры идеально подходят для обеспечения безопасного сетевого подключения в современных средах центров обработки данных и хранения. Кроме того, ConnectX-6 Dx предлагает улучшения с помощью аппаратного ускорения Zero Touch RoCE и VirtIO.

ConnectX-6 Dx доступен в низкопрофильных форм-факторах PCIe Gen 4.0, OCP 3.0 и OCP 2.0 с интерфейсными разъемами SFP28, SFP56 или QSFP56.

ConnectX-6 Lx

ConnectX-6 Lx - это самый экономичный, безопасный и гибкий SmartNIC в отрасли для облачных, пограничных, телекоммуникационных и корпоративных рабочих нагрузок. ConnectX-6 Lx SmartNIC обеспечивает до двух портов 25GbE или однопортовое подключение 50GbE

ConnectX-6 Lx предоставляет лучшие в своем классе возможности, включая ускорение виртуализации сети, безопасность инфраструктуры и расширенные сетевые функции для SDN, обеспечивая при этом наилучшую совокупную стоимость владения и эффективность.

ConnectX-6 Lx предлагает инновационные аппаратные механизмы разгрузки, в том числе шифрование / дешифрование IPsec для ускорения безопасного подключения к сети, а также разгрузка Mellanox ASAP² - ускоренная коммутация и пакетная обработка для SR-IOV и VirtIO.

Адаптеры доступны в форм-факторах низкопрофильной платы PCIe или OCP 3.0 для серверов PCIe Gen 3.0 или Gen 4.0.

Таблица основных характеристик адаптеров ConnectX-6 компании Mellanox

Характеристика ConnectX-6 ConnectX-6 Dx ConnectX-6 Lx Основные параметры Количество портов 1, 2 1, 2 1, 2 Скорость передачи на порт Gb/s 1, 10, 25, 40, 50, 100, 200 1, 10, 25, 40, 50, 100, 200 (x1) 1, 10, 25, 50 (x1) Интерфейс PCI Express (PCIe) 2x Gen 3.0 x16; Gen 4.0 x16 Gen 4.0 x16 Gen 4.0 x8 Коннекторы QSFP56 SFP56; QSFP56 SFP28; QSFP28 Пакетов/сек (млн.) 215 215 75 Задержка передачи для RoCE

на максимальной скорости, мкс0,8 0,8 не известно OOO RDMA (Adaptive Routing) * + + + Dynamically Connected Transport + + + Flexible Pipeline Programmability + + + Packet Pacing + + + Host Chaining ++ ++ + Host Management + + + Embedded PCIe Switch + + - RoCE Zero Touch RoCE + + + RoCE Selective Repeat - + + RoCE Programmable Congestion Control - + - Storage NVMe-oF Target Offload + + + T-10 Dif/Signature Handover + + - Burst Buffer Offloads + + + Security Secure Firmware Update + + + Secure Boot (HW RoT) - + + Connection Tracking (L4 firewall) + ++ ++ IPsec and TLS data-in-motion inline encryption/

decryption- + только IPsec Block-level Encryption/Decryption (AES-XTS) + + - Виртуализация SR-IOV 8 PFs/host, 1K VFs 8 PFs, 1K VFs/port 8 PFs, 512 VFs/port Mellanox Multi-Host 8 hosts 4 hosts - Congestion Control (ECN) + + + ASAP2 (Virtual Switch offload) + + + VirtIO Hardware Emulation - + + RoCE over Overlay Networks + + + Stateless Offloads for Overlay Network Tunneling

Protocols+ + + Hardware Offload of Encapsulation and Decapsulation

of VXLAN, NVGRE, and GENEVE Overlay Networks+ +GTP +GTP Доступные форм-факторы Low Profile PCIe + + + OCP 2.0 - + TBD OCP 3.0 (SFF) + + + Mellanox Socket Direct + + - * OOO (Out-of-Order)RDMA (Adaptive Routing)

В определенных конфигурациях сетевой фабрики, пакеты могут проходить разными путями по сети от источника к месту назначения. Это приводит к тому, что пакеты принимаются не по порядку. Благодаря технологии Out-of-Order (OOO) эти пакеты теперь можно обрабатывать, а не отбрасывать, чтобы избежать повторной передачи, это дает:

- лучшее использование сетевого трафика;

- уменьшение задержки передачи

Данные будут помещаться в память хост-адаптера не по порядку, поскольку получаются сообщения не по порядку.ConnectX-5 EN Mellanox...

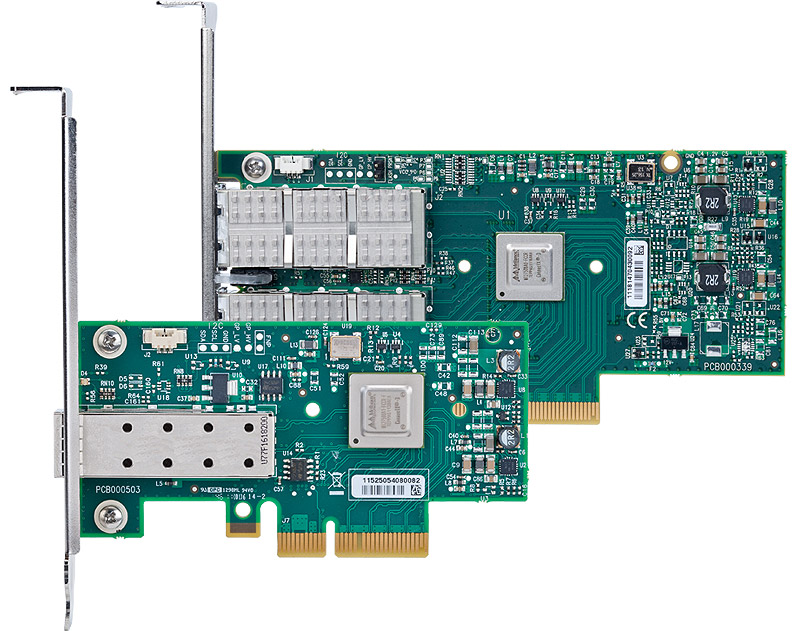

Адаптеры 100Gb/s Ethernet ConnectX-5 EN Mellanox

Интеллектуальная карта сетевого адаптера ConnectX-5 EN Mellanox с поддержкой RDMA с расширенными возможностями разгрузки приложений для высокопроизводительных вычислений, платформ Web2.0, Cloud и Storage/

ConnectX-5 EN поддерживает два порта 100Gb Ethernet-соединений, обеспечивая низкую суб-600ns задержку, чрезвычайно высокие скорости передачи сообщений, коммутацию PCIe и NVMe over Fabric. ConnectX-5 обеспечивает наивысшую производительность и наиболее гибкое решение для самых требовательных приложений и рынков, таких как машинное обучение, аналитика данных и многое другое.

Применение ConnectX-5 EN в высокопроизводительных системах (HPC)

ConnectX-5 обеспечивает высокую пропускную способность, низкую задержку и высокую вычислительную эффективность для высокопроизводительных, масштабируемых на основе данных и масштабируемых платформ вычисления и хранения. ConnectX-5 предлагает усовершенствования инфраструктуры HPC, предоставляя разгрузку MPI и SHMEM / PGAS и Rendezvous Tag Matching, аппаратную поддержку для операций записи и чтения RDMA бездействия, а также дополнительную поддержку Network Atomic и PCIe Atomic.

ConnectX-5 EN использует технологию RoCE (RDMA over Converged Ethernet), обеспечивающую низкую задержку и высокую производительность. ConnectX-5 расширяет возможности сети RDMA, дополняя возможностями коммутационной адаптивной маршрутизации и поддерживая данные, поставляемые вне порядка, сохраняя при этом упорядоченную семантику завершения, обеспечивая многолучевую надежность и эффективную поддержку для всех сетевых топологий, включая DragonFly и DragonFly +. ConnectX-5 также поддерживает разгрузку буфера для фоновой контрольной точки без вмешательства в основные операции ЦП и инновационный транспортный сервис Dynamic Connected Transport (DCT) для обеспечения максимальной масштабируемости для вычислительных систем и систем хранения.Применение ConnectX-5 EN в системах хранения

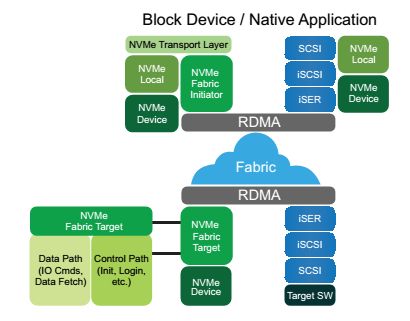

Рис. 1. NVMf - доступ к удаленному NVMe устройству через RDMA

Накопители NVMe набирают популярность, предлагая очень быстрый доступ к хранилищу. Развивающийся протокол NVMe over Fabric (NVMf) использует возможности RDMA для удаленного доступа. ConnectX-5 предлагает дополнительные усовершенствования, предоставляя целевые разгрузки NVMf, обеспечивая очень эффективный доступ к хранилищу NVMe без вмешательства ЦП и, таким образом, улучшая производительность и уменьшая задержку. Кроме того, встроенный переключатель PCIe позволяет клиентам создавать автономные устройства хранения данных или устройства для машинного обучения. Как и в предыдущих поколениях адаптеров ConnectX, стандартные протоколы доступа к блокам и файлу могут использовать RoCE для высокопроизводительного доступа к хранилищу. Консолидированная сеть вычислений и хранения обеспечивает значительные преимущества в отношении затрат по сравнению с разделенными сетями.

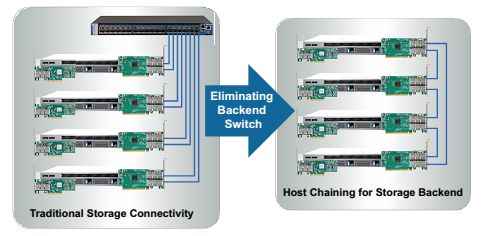

ConnectX-5 обеспечивает инновационный дизайн стойки хранения, Host Chaining, с помощью которого разные серверы могут соединяться напрямую, без использования коммутатора Top of the Rack (ToR). В качестве альтернативы можно использовать технологию Multi-Host, которая была впервые введена в серии ConnectX-4.

Рис. 2. Host Chaining - соединение нескольких серверов без коммутатора

Технология Mellanox Multi-Host ™, когда она включена, позволяет подключать несколько хостов к одному адаптеру, разделяя интерфейс PCIe на несколько независимых интерфейсов. С помощью различных новых вариантов дизайна стойки ConnectX-5 снижает совокупную стоимость владения (TCO) в дата-центре за счет сокращения капитальных затрат (кабелей, сетевых адаптеров и расходов на коммутатор) и сокращения OPEX путем сокращения количества портов и общего потребления энергии.

Новые возможности, реализованные в ConnectX-5 EN Mellanox

- Аппаратная разгрузка Tag Matching и Rendezvous

- Адаптивная маршрутизация на надежном транспорте

- Разгрузка буферов для фоновой контрольной точки

- Разгрузка NVMe поверх фабрики (NVMf)

- Исключение выходного ключа по цепочке узлов

- Встроенный коммутатор PCIe

- Расширенные выгрузки vSwitch / vRouter

- Поддержка Flexible Pipeline

- RoCE для сетей Overlay

- Поддержка PCIe Gen 4

ConnectX-4 EN Mellanox...

Адаптеры 100 Gb Ethernet ConnectX-4 EN Mellanox

ConnectX®-4 EN обеспечивает исключительную высокую производительность для самых требовательных центров обработки данных, открытых и частных облаков, приложений Web2.0 и BigData и систем хранения данных, позволяющих сегодняшним корпорациям соответствовать требованиям, обусловленными взрывным ростом объема данных.

ConnectX-4 EN обеспечивает непревзойденную комбинацию пропускной способности 100 Гбит / с на каждый поррт, самую низкую задержку и многочисленные аппаратные разгрузки, которые соответствуют центрам обработки, вычисления и хранения данных как существующим, так и следующего поколения.Преимущества ConnectX-4 EN Mellanox

- Высокопроизводительные платы для приложений, требующих высокой пропускной способности, низкой латентности и высокой скорости передачи сообщений

- Ведущая в отрасли пропускная способность и латентность для приложений Web 2.0, Cloud и Big Data

- Интеллектуальное соединение для платформ x86, Power, ARM и GPU для вычислений и хранения

- Передовая производительность в виртуализированных оверлейных сетях

- Эффективная консолидация ввода-вывода, снижение затрат и сложности центра обработки данных

- Ускорение виртуализации

- Энергоэффективность

Ключевые особенности ConnectX-4 EN Mellanox

- Скорость передачи 100 Gb/s на каждый порт

- Скорости 1/10/25/40/50/100 Gb/s

- Доступны адаптеры с одним и двумя портами

- Аппаратная разгрузка Erasure Coding

- Передача подписи T10-DIF

- Аппаратная виртуализация

- Ускоренное переключение и обработка пакетов (ASAP2)

- Низкая латентность RDMA по конвергентному Ethernet (RoCE)

- Разгрузка ЦП от транспортных операций

- Аппаратная разгрузка приложений

- Ускорение связи Mellanox PeerDirect ™

- Аппаратные разгрузки для инкапсулированного трафика NVGRE, VXLAN и GENEVE

- Комплексное QoS и контроль перегрузки

- Аппаратная виртуализация ввода-вывода

Технологии, реализованные в адаптерах ConnectX-4 EN

ASAP2 ™

Mellanox ConnectX-4 EN предлагает технологию ускоренного переключения и обработки пакетов (ASAP2) для выполнения операций разгрузки в гипервизоре, включая путь передачи данных, парсинг пакетов, инкапсуляцию / декапсуляцию VxLAN и NVGRE.

ASAP2 реализует разгрузку, аппаратно обрабатывая данные с помощью SR-IOV. При этом, обработка управления используемое в современных программных решениях, обрабатывается без изменений. В результате достигается значительно более высокая производительность без соответствующей загрузки ЦП. ASAP2 имеет два формата: ASAP2 Flex ™ и ASAP2 Direct ™. Одним из примеров виртуального коммутатора, который ASAP2 может разгружать, является OpenVSwitch (OVS).

RDMA по конвергентному Ethernet (RoCE)

ConnectX-4 EN поддерживает спецификации RoCE, обеспечивая низкую задержку и высокую производительность по сетям Ethernet. Используя возможности мостового соединения центра обработки данных (DCB), а также расширенные аппаратные средства управления перегрузкой ConnectX-4 Lx EN, RoCE обеспечивает эффективные услуги RDMA с низкой задержкой по сетям уровня 2 и уровня 3.

Mellanox PeerDirect ™

Связь PeerDirect ™ обеспечивает высокоэффективный RDMA-доступ, устраняя ненужные внутренние копии данных между компонентами шины PCIe (например, от GPU до CPU) и, следовательно, значительно сокращает время выполнения приложений. Технология расширенного ускорения ConnectX-4 Lx EN позволяет повысить эффективность и масштабируемость кластера до десятков тысяч узлов.

Передача подписи T10-DIF/PI

ConnectX-4 EN поддерживает аппаратную проверку информации о поле / защите информации T10 Data Integrity Field / Protection Information (T10-DIF/PI), уменьшая накладные расходы процессора и ускоряя доставку данных в приложение. Передача подписи обрабатывается адаптером на входных и / или выходных пакетах, уменьшая нагрузку на ЦП на машинах инициатора и / таргета.

Ускорение хранения

Приложения хранения будут видеть улучшенную производительность с более высокой пропускной способностью ConnectX-4 EN. Более того, стандартные протоколы доступа к блокам и файлу могут использовать RoCE для высокопроизводительного доступа к хранилищу. Консолидированная сеть вычислений и хранения обеспечивает значительные преимущества в отношении затрат по сравнению с разделенными сетями.

Распределенный RAID

ConnectX-4 EN обеспечивает расширенную возможность разгрузки Erasure Coding. Технология позволяет создать распределенный избыточный массив недорогих дисков (RAID), объединяя несколько дисков в логическую единицу с целью получения избыточности данных и повышения производительности. Функция ConnectX-4 Lx EN представляет расчеты избыточных блоков данных кодом Reed-Solomon, которые вместе с RDMA обеспечивают высокую производительность и надежный доступ к хранилищу.

ConnectX-4 Lx EN...

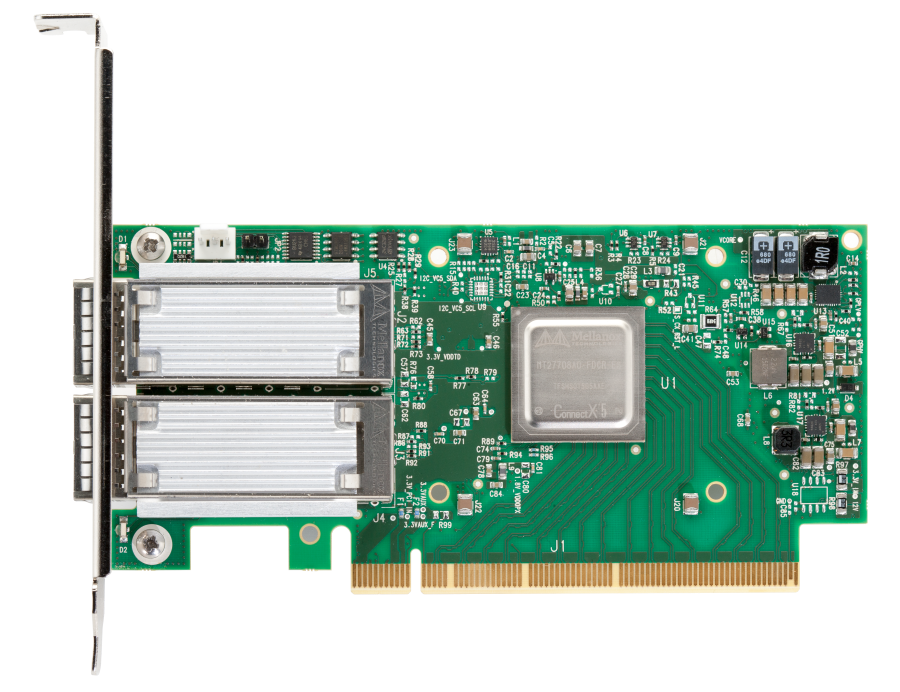

Адаптеры 10/25/40/50 Gb Ethernet ConnectX-4 Lx EN Mellanox

10/25/40/50 Gigabit Ethernet адаптеры, поддерживающие технологию Multi-Host ™, RDMA, инкапсуляцию / декапсуляцию.

Сетевой контроллер ConnectX-4 Lx EN с 1/10/25/40 / 50Gb / s Ethernet связывает виртуализованные инфраструктурные задачи, обеспечивает лучшую в своем классе производительность для различных рынков и приложений. Обеспечение подлинной аппаратной изоляции ввода-вывода с непревзойденной масштабируемостью и эффективностью, достижение наиболее рентабельного и гибкого решения для Web 2.0, Cloud, аналитики данных, баз данных и платформ хранения.

Mellanox ConnectX-4 Lx EN обеспечивает непревзойденную комбинацию пропускной способности 1, 10, 25, 40 и 50 Гбит, субмикросекундную задержку и скорость передачи сообщений в 75 миллионов пакетов в секунду. Он включает встроенную аппаратную поддержку RDMA через Converged Ethernet, механизмы разгрузки без учета состояния (stateless offload engines), Overlay Networks и технологию GPUDirect®.

Преимущества ConnectX-4 Lx EN Mellanox

- Высокопроизводительные платы для приложений, требующих высокой пропускной способности, низкой латентности и высокой скорости передачи сообщений

- Ведущая в отрасли пропускная способность и латентность для приложений Web 2.0, Cloud и Big Data

- Интеллектуальное соединение для платформ x86, Power, ARM и GPU для вычислений и хранения

- Передовая производительность в виртуализированных оверлейных сетях

- Эффективная консолидация ввода-вывода, снижение затрат и сложности центра обработки данных

- Ускорение виртуализации

- Энергоэффективность

Ключевые особенности ConnectX-4 Lx EN Mellanox

- Скорости 1/10/25/40/50 Gb/s

- Доступны опции с одним и двумя портами

- Аппаратная разгрузка Erasure Coding

- Аппаратная виртуализация

- Ускоренное переключение и обработка пакетов (ASAP2)

- Низкая латентность RDMA по конвергентному Ethernet (RoCE)

- Разгрузка ЦП от транспортных операций

- Аппаратная разгрузка приложений

- Ускорение связи Mellanox PeerDirect ™

- Аппаратные разгрузки для инкапсулированного трафика NVGRE, VXLAN и GENEVE

- Комплексное QoS и контроль перегрузки

- Аппаратная виртуализация ввода-вывода

Технологии, реализованные в адаптерах ConnectX-4 Lx EN

ASAP2 ™

Mellanox ConnectX-4 Lx EN предлагает технологию ускоренного переключения и обработки пакетов (ASAP2) для выполнения операций разгрузки в гипервизоре, включая путь передачи данных, парсинг пакетов, инкапсуляцию / декапсуляцию VxLAN и NVGRE.

ASAP2 реализует разгрузку, аппаратно обрабатывая данные с помощью SR-IOV. При этом, обработка управления используемое в современных программных решениях, обрабатывается без изменений. В результате достигается значительно более высокая производительность без соответствующей загрузки ЦП. ASAP2 имеет два формата: ASAP2 Flex ™ и ASAP2 Direct ™. Одним из примеров виртуального коммутатора, который ASAP2 может разгружать, является OpenVSwitch (OVS).

RDMA по конвергентному Ethernet (RoCE)

ConnectX-4 Lx EN поддерживает спецификации RoCE, обеспечивая низкую задержку и высокую производительность по сетям Ethernet. Используя возможности мостового соединения центра обработки данных (DCB), а также расширенные аппаратные средства управления перегрузкой ConnectX-4 Lx EN, RoCE обеспечивает эффективные услуги RDMA с низкой задержкой по сетям уровня 2 и уровня 3.

Mellanox PeerDirect ™

Связь PeerDirect ™ обеспечивает высокоэффективный RDMA-доступ, устраняя ненужные внутренние копии данных между компонентами шины PCIe (например, от GPU до CPU) и, следовательно, значительно сокращает время выполнения приложений. Технология расширенного ускорения ConnectX-4 Lx EN позволяет повысить эффективность и масштабируемость кластера до десятков тысяч узлов.

Ускорение хранения

Приложения хранения будут видеть улучшенную производительность с более высокой пропускной способностью ConnectX-4 Lx EN. Более того, стандартные протоколы доступа к блокам и файлу могут использовать RoCE для высокопроизводительного доступа к хранилищу. Консолидированная сеть вычислений и хранения обеспечивает значительные преимущества в отношении затрат по сравнению с разделенными сетями.

Распределенный RAID

ConnectX-4 Lx EN обеспечивает расширенную возможность разгрузки Erasure Coding. Технология позволяет создать распределенный избыточный массив недорогих дисков (RAID), объединяя несколько дисков в логическую единицу с целью получения избыточности данных и повышения производительности. Функция ConnectX-4 Lx EN представляет расчеты избыточных блоков данных кодом Reed-Solomon, которые вместе с RDMA обеспечивают высокую производительность и надежный доступ к хранилищу.

ConnectX-3 Pro EN...

Mellanox ConnectX®-3 EN адаптеры Ethernet 10GbE, 40GbE, 56GbE

Сетевые интерфейсные карты (адаптеры) Mellanox ConnectX-3 EN 10GbE / 40GbE / 56GbE с интерфейсом PCI Express 3.0 обеспечивают высокоскоростную и ведущую в отрасли Ethernet-связь для приложений с управлением производительностью и хранилищ данных в корпоративных центрах данных. Кластеризованные базы данных, веб-инфраструктура и высокочастотный трейдинг - это всего лишь несколько приложений, которые достигнут значительных улучшений пропускной способности и латентности, что приведет к более быстрому доступу, реагированию в реальном времени и большему количеству пользователей на сервер. Mellanox ConnectX-3 EN повышает производительность сети за счет увеличения доступной пропускной способности при одновременном снижении связанной нагрузки на ЦП, особенно в виртуализированных серверных средах.

Выгоды Mellanox ConnectX-3 EN

- 10/40 / 56GbE / s для серверов и хранилища

- Ведущая в отрасли производительность и латентность

- Консолидация ввода-вывода

- Ускорение виртуализации

- Программное обеспечение, совместимое со стандартом

- TCP / UDP / IP и iSCSI

Ключевые особенности Mellanox ConnectX-3 EN- Один и два порта 10/40/56 Gigabit Ethernet

- PCI Express 3.0 (до 8 Гбит / с)

- RDMA поверх Ethernet с минимальными задержками

- Поддержка моста для центров обработки данных

- Разгрузка асинхронного режима TCP / IP на оборудовании

- Управление трафиком через несколько ядер

- Аппаратная виртуализация ввода-вывода

- Интеллектуальная коалесценция прерываний

- Расширенное качество обслуживания

Технологии, использующиеся адаптерами ConnectX-3 EN

RDMA через конвергентный Ethernet

- ConnectX-3 с использованием технологии IBTA RoCE обеспечивает эффективные RDMA сервисы, обеспечивая приложения с чувствительностью к задержкам низкой латентностью и высокой производительностью и пропускной способностью. Благодаря совместимости на уровне канала в существующей инфраструктуре Ethernet, сетевые администраторы могут использовать уже развернутые решения для управления сетями данных.

Ускорение сокетов- Приложения, использующие транспорт TCP / UDP / IP, могут достигать лидирующей в отрасли пропускной способности более 10/40/56GbE. Аппаратные механизмы в ConnectX-3 уменьшают нагрузку на процессор для передачи IP-пакетов, освобождая больше процессорной мощности для работы с приложением. Программное обеспечение ускорения сокетов дополнительно увеличивает производительность для чувствительных к задержкам приложений.

Виртуализация ввода-вывода- ConnectX-3 EN предоставляет выделенные ресурсы адаптера и гарантированную изоляцию и защиту виртуальных машин (VM) на сервере. ConnectX-3 EN позволяет администраторам центров обработки данных лучше использовать сервер и объединять LAN и SAN, одновременно снижая затраты, потребляемую мощность и сложность сети.

Прецизионные центры данных- ConnectX-3 EN IEEE 1588 прецизионная схема протокола синхронизации синхронизирует часы хоста с ведущим синхронизирующим моментом центра обработки данных для точного измерения времени выдачи данных и измерений SLA центра обработки данных. Аппаратные механизмы обеспечивают высокую точность и низкий коэффициент джиттера.

Ускорение хранения- Консолидированная сеть вычислений и хранения обеспечивает значительные преимущества по сравнению с многоярусными сетями. Стандартные протоколы доступа к блокам и файлу могут использовать RDMA для высокопроизводительного доступа к хранилищу.

Качество обслуживания- Распределение ресурсов для каждого приложения или на виртуальную машину предоставляется и защищается расширенным QoS, поддерживаемым ConnectX-3 EN. Уровни обслуживания для нескольких типов трафика могут быть основаны на IETF DiffServ или IEEE 802.1p / Q, позволяющие системным администраторам определять приоритетность трафика с помощью приложения, виртуальной машины или протокола. Эта мощная комбинация QoS и приоритизации обеспечивает конечный мелкомасштабный контроль трафика - обеспечение бесперебойной работы приложений в современных сложных средах.