Нет товаров

Цены указаны с учетом НДС

InfiniBand

Решения на базе InfiniBand Mellanox

Объем обрабатываемой информации растет каждую минуту благодаря смартфонам, социальным сетям, потоковым видео и прочим системам, генерирующим большие объемы данных. Все они требуют широких каналов передачи, чтобы справляться с огромным количеством передаваемых данных.

Из-за экспоненциального роста данных,...

Решения на базе InfiniBand Mellanox

Объем обрабатываемой информации растет каждую минуту благодаря смартфонам, социальным сетям, потоковым видео и прочим системам, генерирующим большие объемы данных. Все они требуют широких каналов передачи, чтобы справляться с огромным количеством передаваемых данных.

Из-за экспоненциального роста данных, генерируемых во всем мире и росту приложений, использующих массированную обработку данных в реальном времени для высокопроизводительных вычислений, аналитики данных, бизнес-аналитики, национальной безопасности и приложений «Интернет вещей», рынок требует более быстрых и эффективных решений для межсетевых соединений.

Согласно отчета "2016+ HPC" компании Intersect360 (2 и 3 квартал 2016 года), InfiniBand по-прежнему является предпочтительным высокопроизводительным системным межсоединением.

Инсталляции InfiniBand в области высокопроизводительных вычислений примерно в два раза превышают совокупные установки Ethernet (10G, 40G и 100G).

Обзор интерфейса Infiniband

Развитием и стандартизацией технологий занимается InfiniBand Trade Association. В настоящее время уже реализованы семь поколений протокола.

| Поколение: | SDR | DDR | QDR | FDR-10 | FDR | EDR | HDR | NDR |

|---|---|---|---|---|---|---|---|---|

| Эффективная пропускная способность, Гбит/с, на 1x шину | 2 | 4 | 8 | 10 | 14 | 25 | 50 | |

| Эффективные скорости для 4x и 12x шин, Гбит/с | 8, 24 | 16, 48 | 32, 96 | 41.25, 123.75 | 54.54, 163.64 | 100, 300 | 200, 600 | |

| Кодирование (бит) | 8/10 | 8/10 | 8/10 | 64/66 | 64/66 | 64/66 | ||

| Типичные задержки, мкс | 5 | 2.5 | 1.3 | 0.7 | 0.7 | 0.5 | ||

| Год появления | 2001, 2003 | 2005 | 2007 | 2011 | 2014 | 2017 | позднее 2020 |

Таблица 1. Производительность систем различных поколений

Отличительной особенностью интерфейса Infiniband является минимизация задержек при передаче данных по каналу связи - они в разы меньше, чем у конкурирующих протоколов. За счет этого резко возрастает производительность чувствительной к задержкам системы в целом.

Применение Infiniband

В полной мере преимущества протокола проявляются в высокопроизводительных вычислительных кластерах, требующих интенсивного обмена данными между узлами кластера. Но применение Infiniband этим не ограничивается. Шина с успехом используется для организации быстрого канала синхронизации в небольших (2 - 4 узла) вычислительных кластерах и распределенных системах хранения информации. Протокол также используют даже для прямого подключения хранилища к серверу (DAS) в случае, если необходимо достичь максимальной производительности системы и скорость получения данных от хранилища играет в ней существенную роль.

Сравнение Infiniband с конкурирующими интерфейсами

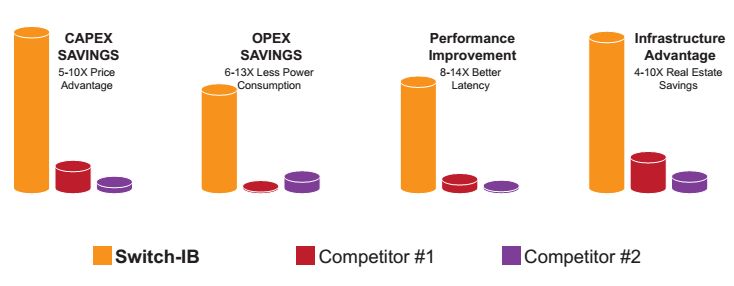

Сравнение производительности и объем необходимого оборудования приведем на основе нового 100Gb/s решения (по материалам Mellanox).

Преимущества, предлагаемые Switch-IB. Switch-IB обеспечивает улучшенную задержку, меньшее энергопотребление, гораздо меньшее количество оборудования и значительное ценовое преимущество. Например, платформа коммутатора Switch IB, работающая на 36 портов EDR и обеспечивающая передачу данных до 7,2 Тбайт / с, дает экономию в размере 4-10 раз по сравнению с решением Cisco, достигающим той же пропускной способности ( 4U Cisco Nexus 6004, работает 96 портов 40 Гбит / с) или с решением Arista 10U ( системы 7050QX).

Рисунок 1. Сравнение производительности Infiniband EDR, Cisco Nexus 6004 (Competitor 1), Arista 7050QX (Competitor 2)

Преимущества EDR (100Gb/s) в сравнении с FDR (56Gb/s)

Классическим сценарием использования преимуществ 100Gb / s линий связи является использование возможностей FDR для серверов и более производительных линий EDR 100Gb / s между коммутаторам стойки (ToR) и коммутаторами агрегации. Это позволяет использовать агрегацию на основе Switch-IB с наивысшей производительностью, имея более высокий уровень портов FDR в ToR, используя соотношение 2: 1 между нисходящими и восходящими портами, которое обеспечивает неблокирующую топологию.

Например, возьмем кластер из 3888 узлов. Сконфигурированный как FDR, кластер требует шесть шасси коммутатора агрегации и 216 переключателей Top-of-Rack (с 18 портами восходящей и нисходящей линии связи), чтобы создать неблокирующий сценарий 1: 1. Но с коммутатором EDR IB (100Gb/s) для поддержания сценария блокировки (соотношение 2: 1) требуется только три шага коммутатора агрегации (связь в два раза по ширине полосы) и 162 коммутатора Top-of-Rack (с 12 восходящими и 24 портами нисходящей линии связи) , Это экономит 37% на оборудовании в центре обработки данных и 25% на потреблении электроэнергии за счет использования меньшего количества коммутаторов.

| Размер кластера, суммарная пропускная способность | Преимущество в затратах на оборудование | Преимущество в затратах электроэнергии |

| 648 узлов - 72Tb/s | 28% | 5% |

| 1296 узлов - 145Tb/s | 37% | 25% |

| 3888 узлов - 435Tb/s | 37% | 25% |

| 11664 узлов - 1.3Pb/s | 37% | 25% |

Таблица 2. Выигрыш при переходе с FDR к EDR

Оборудование InfiniBand Mellanox сгруппировано по типу и принадлежности к определенному протоколу. Перейдите в раздел:

Адпатеры HDR 200Gb/s ConnectX-6 VPI

Адпатеры EDR 100Gb/s ConnectX-5 VPI

Адпатеры EDR 100Gb/s ConnectX-4 VPI

Адпатеры FDR 56Gb/s Connect-IB

Адпатеры EDR 40Gb/s ConnectX-3 Pro VPI

Адпатеры EDR 40/56Gb/s ConnectX-3 VPI

Коммутаторы HDR 200Gb/s QM8700 series

Коммутаторы EDR 100Gb/s SB7800 Series

Коммутаторы EDR 100Gb/s SB7700 Series

Коммутаторы FDR 56Gb/s SX6710 Series

Коммутаторы FDR 56Gb/s SX6000 Series

InfiniBand Нет товаров в этой категории.

Подкатегории

Адаптеры Infiniband

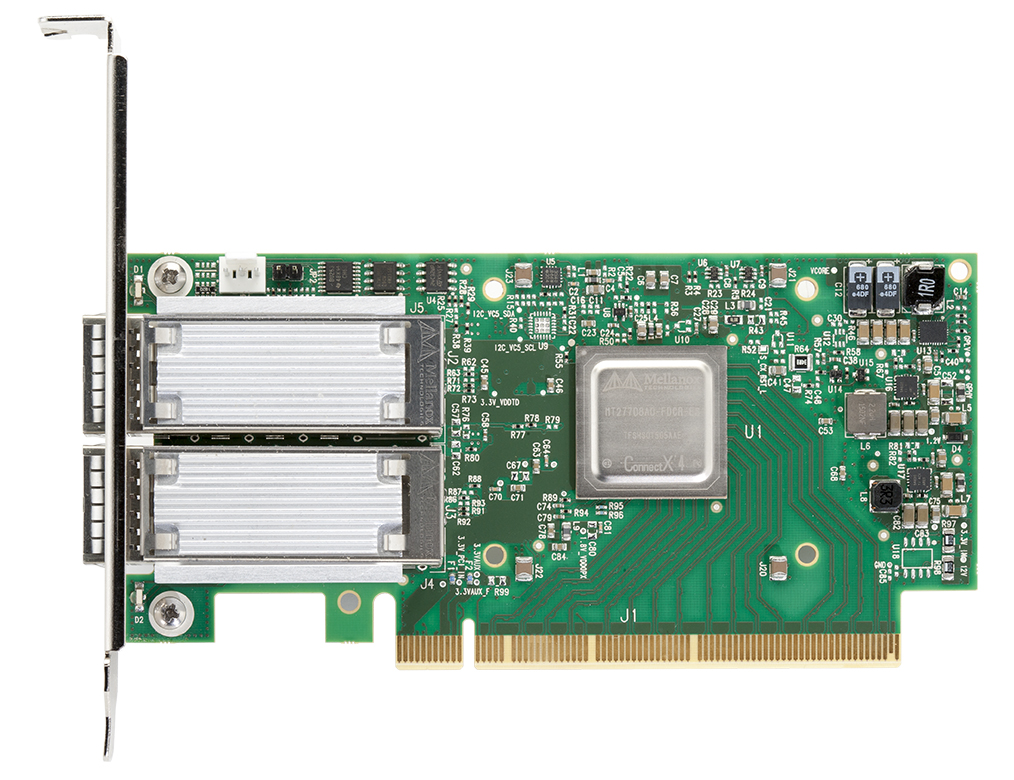

Адаптеры HCA InfiniBand Mellanox Connectx

Обзор

Адаптеры Mellanox InfiniBand серии Connectx обеспечивают повышенные уровни ИТ-производительности, эффективности и масштабируемости ИТ-центра.

Mellanox сохраняет свое лидерство, предоставляя адаптеры Host Link InfiniBand HCA) - самое высокопроизводительное решение для межсетевых соединений для корпоративных центров данных, WEB 2.0, облачных вычислений, высокопроизводительных вычислений и встроенных сред. Для высокопроизводительных вычислений требуется высокая пропускная способность, низкая латентность (задержки передачи данных) и разгрузка процессора, чтобы получить максимальную эффективность сервера и производительность приложений. Mellanox HCAs обеспечивают максимальную пропускную способность и минимальную задержку любого стандартного межсоединения, что обеспечивает эффективность КПД более 95%.

Для высокопроизводительных вычислений требуется высокая пропускная способность, низкая латентность (задержки передачи данных) и разгрузка процессора, чтобы получить максимальную эффективность сервера и производительность приложений. Mellanox HCAs обеспечивают максимальную пропускную способность и минимальную задержку любого стандартного межсоединения, что обеспечивает эффективность КПД более 95%.

Для центров обработки данных и облачных вычислений требуются услуги ввода-вывода, такие как пропускная способность, консолидация и унификация, а также гибкость. HCA от Mellanox поддерживают консолидацию трафика LAN и SAN и обеспечивают аппаратное ускорение для виртуализации серверов.

Гибкость виртуального протокола Interconnect® (VPI) обеспечивает соединение InfiniBand, Ethernet, мостовое соединение с данными, подключение EoIB, FCoIB и FCoE.Преимущества Mellanox InfiniBand адаптеров Connectx

- Производительность кластера мирового класса

- Высокопроизводительный сетевой доступ и доступ к хранилищу

- Эффективное использование вычислительных ресурсов

- Передовая производительность в виртуализированных оверлейных сетях (VXLAN и NVGRE)

- Увеличение количества виртуальных машин на сервер

- Гарантированная пропускная способность и услуги с низкой задержкой

- Надежный транспорт

- Эффективная консолидация ввода-вывода, снижение затрат и сложности центра обработки данных

- Масштабируемость до десятков тысяч узлов

Целевые приложения

- Высокопроизводительные параллельные вычисления

- Виртуализация центров обработки данных

- Общественные и частные облака

- Крупномасштабные приложения для Web 2.0 и анализа данных

- Кластеризованные приложения баз данных, параллельные запросы СУРБД, хранилища с высокой пропускной способностью

- Латентные чувствительные приложения, такие как финансовый анализ и торговля

- Приложения для хранения данных, такие как резервное копирование, восстановление, зеркалирование и т. д.

Коммутаторы Infiniband

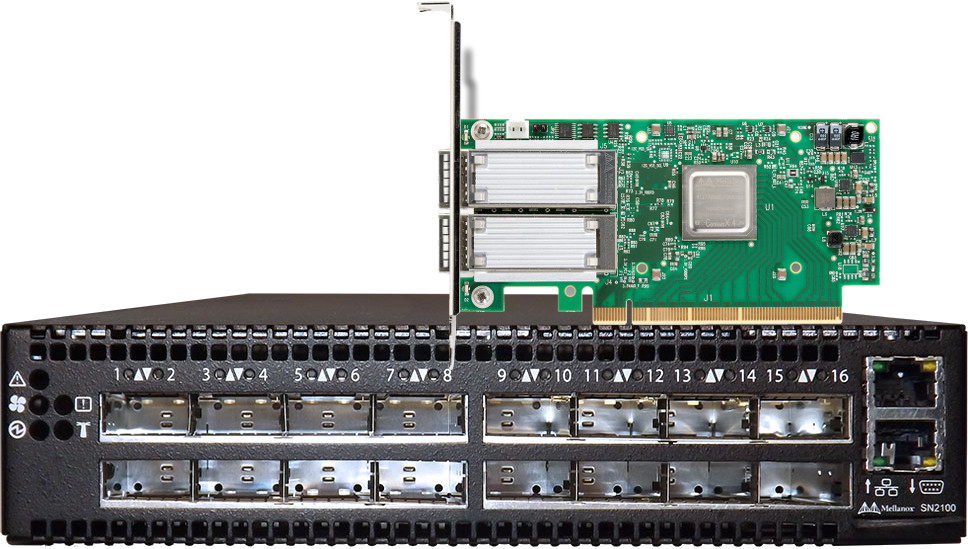

Коммутаторы InfiniBand Mellanox

Семейство коммутаторов InfiniBand от Mellanox обеспечивает максимальную производительность и плотность портов для управления сетью, позволяющую создавать вычислить кластеры и конвергентные центры обработки данных для работы в любом масштабе, одновременно снижая эксплуатационные расходы и сложность инфраструктуры.

Централизованное управление и программируемость сети внешними приложениями обеспечивает экономичную, простую и плоскую инфраструктуру межсоединений.

Обзор

Коммутаторы Mellanox включают в себя широкий ассортимент переключателей Edge и Director, поддерживающих скорость портов 40, 56, 100 и 200 Гбит / с, содержащих от 8 портов до 800 портов. Эти коммутаторы позволяют ИТ-менеджерам создавать наиболее рентабельные и масштабируемые коммутационные фабрики, начиная от небольших кластеров до 10 тыс. узлов и могут переносить конвергентный трафик, сочетая гарантированную пропускную способность, высочайший уровень качества обслуживания с наивысшей производительностью.

Пограничные коммутаторы (Edge Switch)

От 8 до 40 портов без блокировки от 40 до 200 Гбит / с InfiniBand Switch Systems

Семейство коммутационных систем Mellanox обеспечивает наивысшие технические решения в форм-факторе 1U, обеспечивая пропускную способность до 16 Тб / с с минимальной задержкой между портами. Эти пограничные коммутаторы являются идеальным выбором для подключения к верхней части стойки или для создания небольших и средних кластеров.

Пограничные коммутаторы управляемые и неуправляемые ( управляемые извне ), предназначены для создания наиболее эффективных коммутационных фабрик с использованием передовых технологий переключения InfiniBand, таких как адаптивная маршрутизация, контроль перегрузки и качество обслуживания.Director Switches

От 108 до 800 портов с полной двунаправленной пропускной способностью от 40 до 200 Гбит / с InfiniBand Switch.

Коммутаторы Mellanox для систем обеспечивают решение с наивысшей плотностью коммутации, масштабируемое от 8,64 Тб / с до 320 Тбайт / с пропускной способности в одном корпусе с низкой задержкой и максимальной скоростью порта до 200 Гбит / с. Его интеллектуальный дизайн обеспечивает беспрецедентный уровень производительности и упрощает сбор кластеров, которые могут масштабироваться до тысяч узлов.

Директор InfiniBand Mellanox переводит коммутаторы Director для критически важных приложений в класс доступных. Лезвия, модули управления, а также блоки питания и вентиляторы являются элементами с «горячей» заменой, что позволяет сократить время простоя.Технологии, использующиеся в коммутаторах Infiniband Mellanox

Virtual Protocol Interconnect (VPI)

Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

Масштабируемый иерархический протокол агрегирования и сокращения (Scalable Hierarchical Aggregation and Reduction Protocol, SHARP)

Самые интеллектуальные сетевые коммутаторы в мире предназначены для использования внутрисетевых вычислений через технологию Co-Design SHARP. Архитектура Co-Design позволяет использовать все активные центры обработки данных для ускорения коммуникационных инфраструктур, что приводит к увеличению производительности приложений и оптимизации использования ЦП.Кабели, оптические...

Активные и пассивные кабели для сети InfiniBand на скорость передачи 40/56 Гб/с, 100 Гб/с. Трансиверы (оптические модули).