Нет товаров

Цены указаны с учетом НДС

Адаптеры Infiniband

Каталог

Адаптеры HCA InfiniBand Mellanox Connectx

Обзор

Адаптеры Mellanox InfiniBand серии Connectx обеспечивают повышенные уровни ИТ-производительности, эффективности и масштабируемости ИТ-центра.

Mellanox сохраняет свое лидерство, предоставляя адаптеры Host Link InfiniBand HCA) - самое высокопроизводительное решение для межсетевых соединений для ...

Адаптеры HCA InfiniBand Mellanox Connectx

Обзор

Адаптеры Mellanox InfiniBand серии Connectx обеспечивают повышенные уровни ИТ-производительности, эффективности и масштабируемости ИТ-центра.

Mellanox сохраняет свое лидерство, предоставляя адаптеры Host Link InfiniBand HCA) - самое высокопроизводительное решение для межсетевых соединений для корпоративных центров данных, WEB 2.0, облачных вычислений, высокопроизводительных вычислений и встроенных сред.

Для высокопроизводительных вычислений требуется высокая пропускная способность, низкая латентность (задержки передачи данных) и разгрузка процессора, чтобы получить максимальную эффективность сервера и производительность приложений. Mellanox HCAs обеспечивают максимальную пропускную способность и минимальную задержку любого стандартного межсоединения, что обеспечивает эффективность КПД более 95%.

Для высокопроизводительных вычислений требуется высокая пропускная способность, низкая латентность (задержки передачи данных) и разгрузка процессора, чтобы получить максимальную эффективность сервера и производительность приложений. Mellanox HCAs обеспечивают максимальную пропускную способность и минимальную задержку любого стандартного межсоединения, что обеспечивает эффективность КПД более 95%.

Для центров обработки данных и облачных вычислений требуются услуги ввода-вывода, такие как пропускная способность, консолидация и унификация, а также гибкость. HCA от Mellanox поддерживают консолидацию трафика LAN и SAN и обеспечивают аппаратное ускорение для виртуализации серверов.

Гибкость виртуального протокола Interconnect® (VPI) обеспечивает соединение InfiniBand, Ethernet, мостовое соединение с данными, подключение EoIB, FCoIB и FCoE.

Преимущества Mellanox InfiniBand адаптеров Connectx

- Производительность кластера мирового класса

- Высокопроизводительный сетевой доступ и доступ к хранилищу

- Эффективное использование вычислительных ресурсов

- Передовая производительность в виртуализированных оверлейных сетях (VXLAN и NVGRE)

- Увеличение количества виртуальных машин на сервер

- Гарантированная пропускная способность и услуги с низкой задержкой

- Надежный транспорт

- Эффективная консолидация ввода-вывода, снижение затрат и сложности центра обработки данных

- Масштабируемость до десятков тысяч узлов

Целевые приложения

- Высокопроизводительные параллельные вычисления

- Виртуализация центров обработки данных

- Общественные и частные облака

- Крупномасштабные приложения для Web 2.0 и анализа данных

- Кластеризованные приложения баз данных, параллельные запросы СУРБД, хранилища с высокой пропускной способностью

- Латентные чувствительные приложения, такие как финансовый анализ и торговля

- Приложения для хранения данных, такие как резервное копирование, восстановление, зеркалирование и т. д.

Адаптеры Infiniband Нет товаров в этой категории.

Подкатегории

ConnectX-6 VPI...

Адаптеры 200Gb/s ConnectX-6 VPI Mellanox

ConnectX-6 является новаторским дополнением к ведущим в отрасли адаптерам Mellanox ConnectX. В дополнение ко всем существующим инновационным функциям прошлых версий ConnectX-6 предлагает ряд улучшений для дальнейшего повышения производительности и масштабируемости. ConnectX-6 VPI поддерживает скорости HDR, HDR100, EDR, FDR, QDR, DDR и SDR InfiniBand, а также скорости Ethernet 200, 100, 50, 40, 25 и 10 Гбит / с.

Новые возможности Mellanox ConnectX-6

- Высокая производительность

- До 200 Гбит / с для каждого порта

- Максимальная пропускная способность 200 Гбит / с

- До 200 миллионов сообщений в секунду

- Менее 0.6 мкс латентность

- Аппаратное шифрование на уровне блока XTS-AES

- Поддержка PCIe Gen3 и PCIe Gen4

Выгоды Mellanox ConnectX-6

- Ведущая в отрасли пропускная способность, низкая латентность, низкое использование ЦП и высокая скорость передачи сообщений выводит адаптеры Mellanox Connecrx-6 в абсолютные лидеры рынка.

- Высокая производительность и самая интеллектуальная структура фабрики для вычислительных инфраструктур и инфраструктур хранения.

- Расширенные возможности хранения данных, включая блокировку на уровне блоков и выгрузку контрольной суммы.

- Технология Host Chaining для экономичной конструкции стойки.

- Интеллектуальное соединение для платформ x86, Power, ARM, GPU и FPGA для вычислений и хранения.

- Интеллектуальный сетевой адаптер, поддерживающий гибкую программируемость.

- Передовая производительность в виртуализированных сетях, включая виртуализацию сетевых функций (NFV).

- Поддержка эффективных возможностей цепочки обслуживания.

- Эффективная консолидация ввода-вывода, снижение затрат и сложности центра обработки данных

Машинное обучение и среды больших данных (Big Data)

Аналитика данных стала важной функцией во многих корпоративных центрах обработки данных, облаках и платформах Hyperscale. Машинное обучение опирается на особенно высокую пропускную способность и низкую задержку для обучения глубоких нейронных сетей и для повышения точности распознавания и классификации. В качестве первой платы адаптера с пропускной способностью 200 Гбит / с ConnectX-6 является идеальным решением для приложений машинного обучения с требуемыми уровнями производительности и масштабируемости. ConnectX-6 использует технологию RDMA для обеспечения низкой латентности и высокой производительности. ConnectX-6 еще больше расширяет возможности RDMA-сети, обеспечивая сквозное управление потоком пакетов на уровне пакетов.

Virtual Protocol Interconnect (VPI)

VPI позволяет использовать один и тот же адаптер как в сети передачи данных Infiniband, так и Ethernet. Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

ConnectX-5 VPI...

Адаптеры ConnectX-5 VPI Mellanox

Адаптеры Mellanox серии ConnectX-5 VPI поддерживает один или два порта со скоростью 100 Гбит/с по протоколу Ethernet или EDR Infiniband с латентностью менее 600 нс. Технология NVMe поверх Fabric обеспечивает максимальную производительность и наиболее гибкое решение для самых требовательных приложений и рынков.

Основные особенности Connectx-5 VPI

Virtual Protocol Interconnect (VPI)

VPI позволяет использовать один и тот же адаптер как в сети передачи данных Infiniband, так и Ethernet. Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

ConnectX-4 VPI...

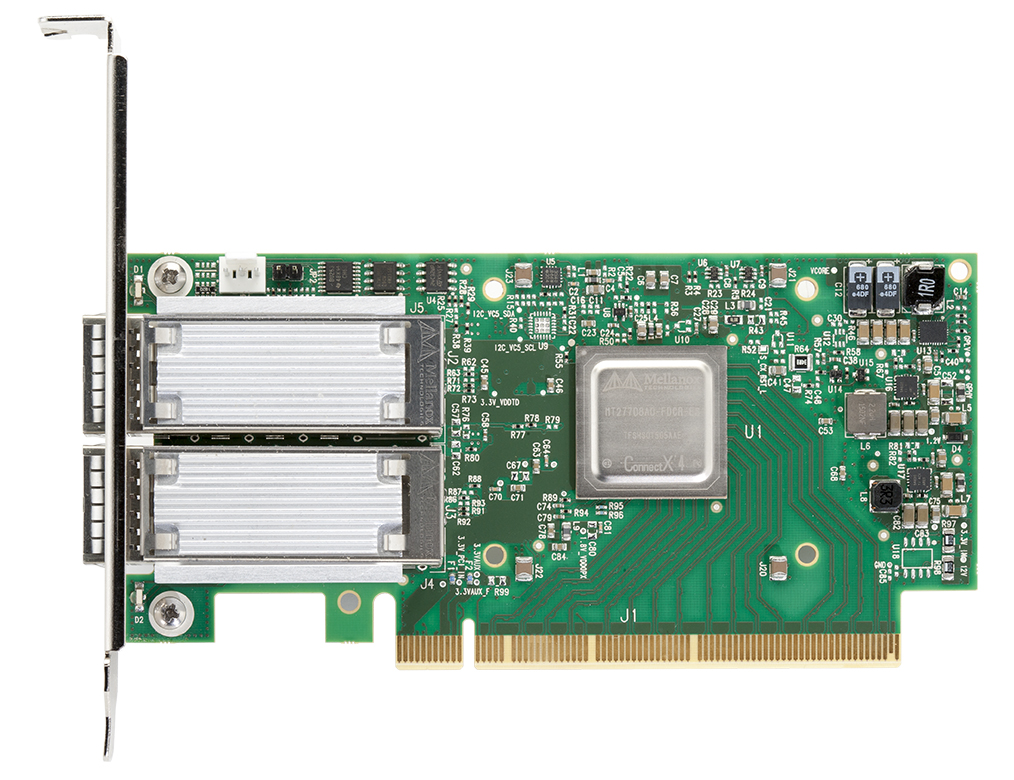

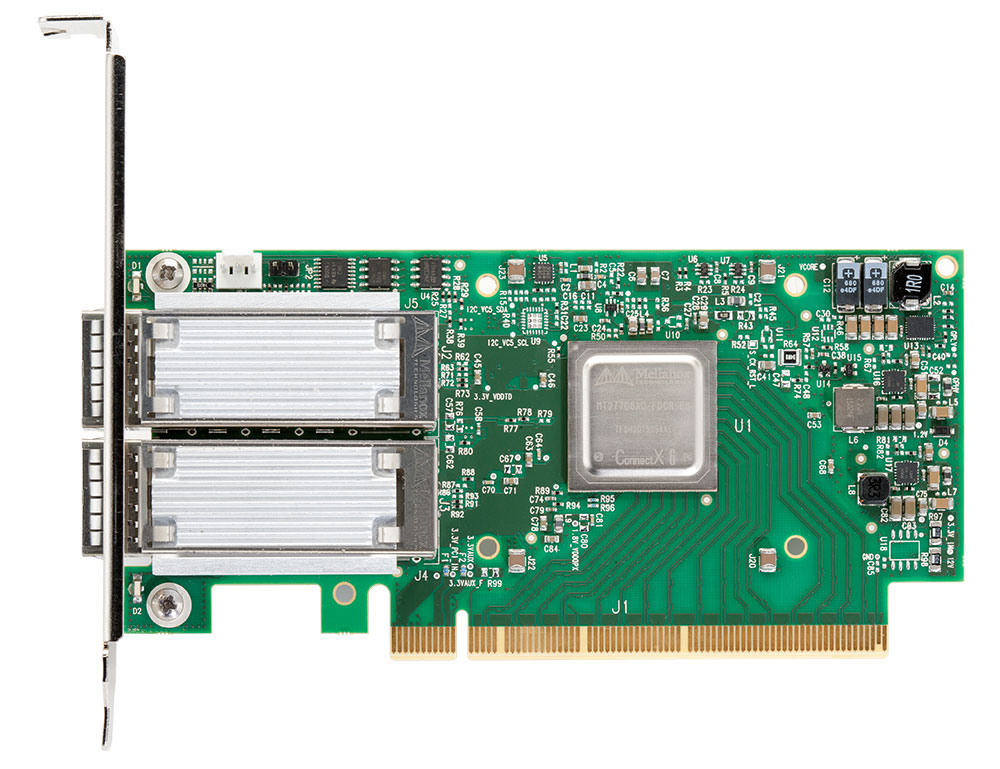

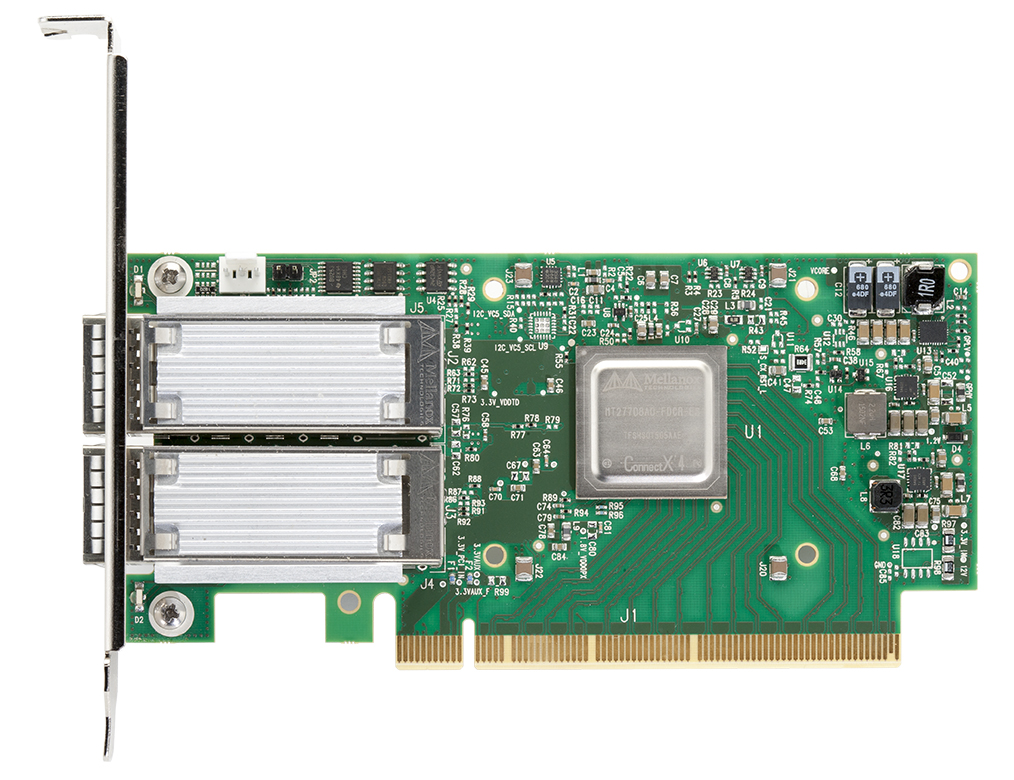

Адаптеры ConnectX-4 VPI Mellanox

Адаптеры серии ConnectX-4 с технологией Virtual Protocol Interconnect (VPI) поддерживают скорость передачи данных EDR 100Gb/s InfiniBand и 100Gb/s Ethernet.

Стремительный рост объема хранимых и обрабатываемых данных сформировал новые требования к высокоскоростным и высокопроизводительным вычислительным центры и центрам хранения данных. ConnectX-4 обеспечивает исключительно высокую производительность для центров обработки данных, публичных и частных облаков, Web2.0 и обработки больших данных (Big Data).

Основные особенности Connectx-4 VPI Mellanox

Virtual Protocol Interconnect (VPI)

VPI позволяет использовать один и тот же адаптер как в сети передачи данных Infiniband, так и Ethernet. Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

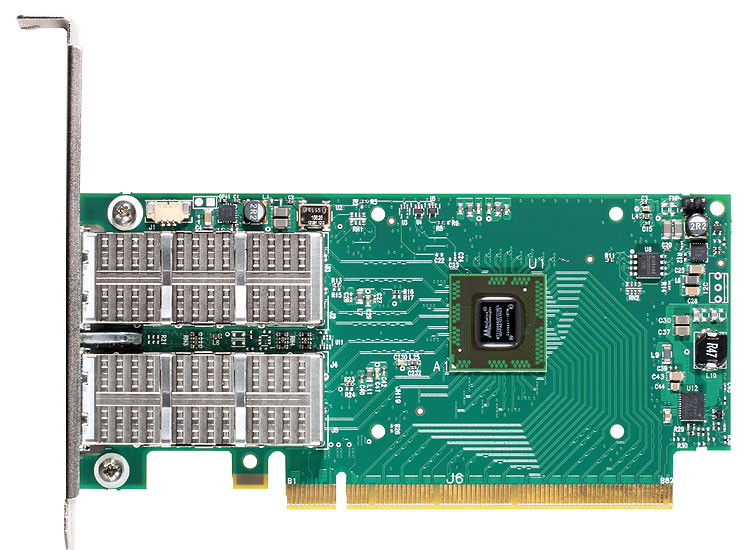

Connect-IB Mellanox 56G

Адаптеры Mellanox InfiniBand FDR 56Gb/s серии Connect-IB

Адаптеры Connect-IB компании Mellanox обеспечивают высокопроизводительное и масштабируемое межсоединение для серверов и систем хранения. Высокопроизводительные вычисления, Web 2.0, облачные приложения, большие данные, финансовые услуги, виртуализированные центры обработки данных и хранилища достигнут значительных улучшений производительности, что приведет к сокращению времени завершения и снижению стоимости за операцию.

Производительность мирового классаConnect-IB обеспечивает максимальную пропускную способность, низкую задержку и эффективность вычислений для приложений, ориентированных на производительность. Максимальная пропускная способность предоставляется через PCI Express 3.0 x16 и два порта FDR InfiniBand, обеспечивая пропускную способность более 100 Гбит / с вместе с низкой задержкой во всех ядрах ЦП. Connect-IB также позволяет системам с PCI Express 2.0 x16 полностью использовать преимущества FDR, обеспечивая как минимум вдвое большую пропускную способность существующих решений PCIe 2.0.

Connect-IB разгружает обработку протокола ЦП и перемещение данных от ЦП к каналу связи, максимизирует эффективность ЦП и ускоряет параллельную и интенсивную работу приложений. Connect-IB поддерживает новые операции с данными, включая непрерывную передачу памяти, которая устраняют ненужные операции копирования данных и накладные расходы ЦП (прямой доступ к памяти, DMA). Дополнительное ускорение приложений достигается с 4-процентным улучшением скорости передачи сообщений по сравнению с предыдущими поколениями адаптеров InfiniBand.Неограниченная масштабируемость

Следующий уровень масштабируемости и производительности требует нового поколения ускорения данных и приложений. MellanoX Messaging (MXM) и коллективный ускоритель Fabric (FCA), использующий технологию CORE-Direct®, ускоряют обмен данными MPI и PGAS, в полной мере используя расширенные возможности Connect-IB. Кроме того, Connect-IB представляет инновационный транспортный сервис Dynamic Transport для обеспечения неограниченной масштабируемости для кластеризации серверов и систем хранения.

Высокопроизводительные системы хранения

Узлы хранения будут видеть улучшенную производительность с более высокой пропускной способностью FDR, а стандартные протоколы доступа к блокам и файлу могут использовать InfiniBand RDMA для повышения производительности. Connect-IB также поддерживает аппаратную проверку информации поля / защиты данных T10 (DIF / PI) и других типов сигнатур, уменьшая накладные расходы процессора и ускоряя данные в приложении. Трансляция подписи и передача обслуживания также выполняются адаптером, что еще больше снижает нагрузку на процессор. Консолидация вычислений и хранения через FDR InfiniBand с Connect-IB обеспечивает превосходную производительность при одновременном снижении затрат и сложностей центра обработки данных.

ConnectX-3 Pro VPI...

Адаптеры Mellanox ConnectX-3 Pro VPI

Карты адаптеров ConnectX-3 Pro с интерфейсом Virtual Protocol Interconnect (VPI), поддерживающие соединение InfiniBand и Ethernet с аппаратными устройствами разгрузки для Overlay Networks («Tunneling»), обеспечивают наиболее эффективное и гибкое решение для межсетевых соединений для серверов PCI Express Gen3, используемых в общественных и частные облака, корпоративные центры обработки данных и высокопроизводительные вычисления.

Преимущества Connetx-3 Pro VPI Mellanox

- Один адаптер для FDR/QDR InfiniBand, 10/40 GbE

- Коммутационные сети Ethernet и Data Center Bridging

- Высочайшая производительность кластеров, сетей и систем хранения данных

- Гарантированная пропускная способность и низкая задержка

- Консолидация ввода-вывода

- Ускорение виртуализации

- Энергоэффективность

- Масштабирование до десятков тысяч узлов

Основные особенности Connetx-3 Pro VPI

- Virtual Protocol Interconnect

- Задержка MPI ping 1 мкс

- До 56 Гбит/с InfiniBand или 40 Gigabit Ethernet на порт

- Доступны одно- и двухпортовые конфигурации

- PCI Express 3.0 (до 8 Гп/с)

- Разгрузка передачи данных с процессора

- Разгрузка приложений

- Ускорение обмена данными с GPU

- Точная синхронизация часов

- Развертывание HW для инкапсулированного трафика NVGRE и VXLAN

- Сквозное управление QoS и контроль перегрузок

- Аппаратная виртуализация ввода-вывода

- Инкапсуляция Fibre Channel (FCoIB или FCoE)

- Инкапсуляция Ethernet (EoIB)

- RoHS-R6

Технологии, используемые в адаптерах Connectx-3 Pro VPI

Технология NVGRE

Для того, чтобы оверлейная сеть могла быть использована, требуется технология для инкапсуляции данных, чтобы она могла туннелировать на уровень 2 и переноситься на уровень 3. Одна из ведущих технологий, которая обеспечивает эту инкапсуляцию и направлена на решение как безопасности, так и масштабируемости. Проблема заключается в виртуализации сети с использованием универсальной инкапсуляции маршрутизации (NVGRE). Технология NVGRE обеспечивает решение для растяжения сети L2 через виртуальную сеть L3 IP.

Концепция NVGRE основана на новой инкапсуляции для трафика виртуальной машины, в которой туннель создается для трафика виртуальной машины с использованием протокола маршрутизации GRE. Он инкапсулирует трафик Layer 2 (Ethernet) виртуальной машины с новыми заголовками MAC и IP и добавляет заголовок NVGRE, который включает сетевой идентификатор Tenant (TNI), 24-битный идентификатор, который радикально расширяет адресное пространство VLAN с 4094 сегментов до 16,7 миллионов доступных идентификаторов, что позволяет решить проблему масштабируемости.RDMA через конвергентный Ethernet

ConnectX-3 Pro компании Mellanox, использующий технологию IBTA RoCE, обеспечивает аналогичные низкозатратные и высокопроизводительные сети Ethernet. Используя возможности моста для центров обработки данных, RoCE обеспечивает эффективные услуги RDMA с низкой задержкой по Ethernet уровня 2. Благодаря взаимодействию на уровне канала в существующей инфраструктуре Ethernet, сетевые администраторы могут использовать существующую структуру центра обработки данных

Ускорение приложений через ускорение сокетов (Sockets Acceleration)

Приложения, использующие транспорт TCP / UDP / IP, могут повысить произодительность благодаря InfiniBand или 10 или 40GbE. Аппаратные устройства разблокировки без учета состояния в ConnectX-3 Pro Mellanox уменьшают расходы процессора на передачу IP-пакетов. Программное обеспечение ускорения сокетов дополнительно увеличивает производительность для чувствительных к задержкам приложений.

Виртуализация ввода-вывода

Технология ConnectX-3 SR-IOV обеспечивает выделенные ресурсы адаптера и гарантированную изоляцию и защиту виртуальных машин (VM) внутри сервера. Виртуализация ввода-вывода с помощью ConnectX-3 Pro позволяет менеджерам центров обработки данных лучше использовать сервер, снижая затраты, мощность и сложность кабельного хозяйства.

Virtual Protocol Interconnect (VPI)

VPI позволяет использовать один и тот же адаптер как в сети передачи данных Infiniband, так и Ethernet. Гибкость виртуального протокола (VPI) позволяет любому стандарту сетевого, кластерного, хранилища и протокола управления беспрепятственно управлять любой конвергентной сетью, используя консолидированный стек программного обеспечения. VPI упрощает проектирование системы ввода / вывода и упрощает ИТ-менеджерам развертывание инфраструктуры, которая отвечает задачам динамического центра обработки данных.

ConnectX-3 VPI...

Адаптеры Mellanox ConnectX-3 VPI

Адаптеры ConnectX-3 с поддержкой Virtual Protocol Interconnect (VPI), InfiniBand и Ethernet представляют собой высокопроизводительные и гибкие коммутационные решения для серверов PCI Express Gen3. Они ориентированы на применение в корпоративных центрах обработки данных, суперкомпьютерах и встраиваемых средах.

Преимущества Connetx-3 VPI